Întotdeauna există un downside. De obicei deduplicarea are nevoie de multă memorie (ca să poată identifica blocurile duble trebuie să aibă idee care-s blocurile pe care le are deja scrise, așa că trebuie să țină un index, și trebuie să încapă în memorie ca să ai performanță cât de cât); dar problema mai complicată e că transformă ceea ce putea fi I/O secvențial (pentru că fișierul ar fi fost scris cât de cât la rând) în I/O random (pentru că blocurile deduplicate sunt în alte zone de disc), iar pe HDD-uri asta e foarte trist, pentru că înseamnă throughput scăzut de zeci de ori fără un controller deștept sau un SSD pentru caching.

You are using an out of date browser. It may not display this or other websites correctly.

You should upgrade or use an alternative browser.

You should upgrade or use an alternative browser.

Soluţie NAS pentru acasă

- Thread starter wirespot

- Start date

Dar ai economisit bani de la luat HDD-uri?

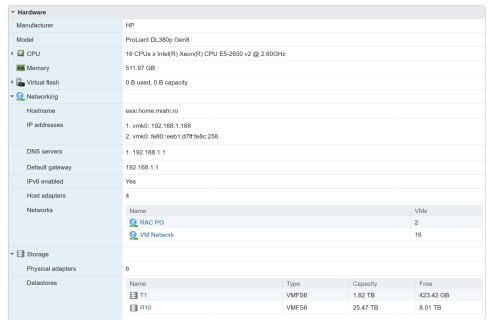

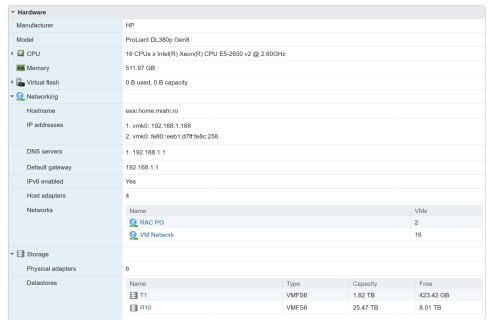

Ultima versiune de NAS, după ce m-am tot lovit de nevoi dubioase (de tipul "testele de performanță bază de date pe un Ryzen 5900x cu 128GB RAM și SSD-uri de 1-5 GB/s nu au vreo legătură cu ce au clienții, fiind mult prea rapid față de serverele lor", "unde naiba mai pun și backup-urile astea de 2TB" sau "aș vrea să fac upgrade la HDD-ul X, dar trebuie să desfac tot NAS-ul ca să ajung la el"). Așa că de câteva luni am trecut la chestii mai serioase. Meet HP DL380 gen8, dual Xeon E5-2650 v2 8-core, 512 GB RAM, 2x10Gbit SFP+, 2 surse, 12 bay-uri hot plug/smart de 3.5" SATA/SAS + 2 SATA interne.

Inițial am luat niște CPU-uri low power, 10-core dar la frecvență mică, erau ok ca consum dar mult prea lente single threaded, așa că am upgradat la 8-core mai rapide. Prețurile componentelor de genul sunt relativ ok pe ebay, CPU-urile au fost vreo 30€.

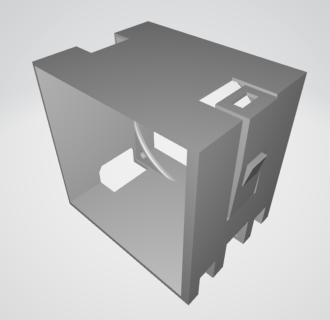

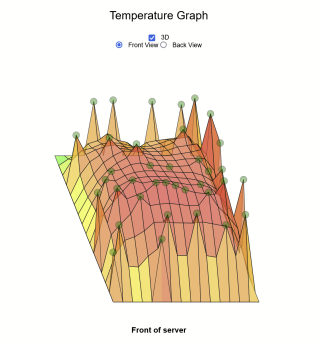

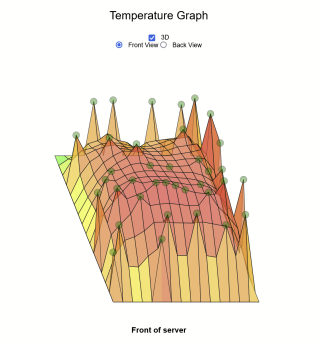

Cea mai mare problemă a fost zgomotul, pentru că serverul stă în pod, unde am și eu biroul. Drăcia are original 6 ventilatoare de 30W fiecare (da, pot consuma 180W doar ventilatoarele), pe care le turează super ok by default (13%), dar dacă încep să se încălzească lucrurile prin el (și are vreo 50 de senzori de temperatură) imediat trece de 50% și e super noisy. La 100% face ca un turboreactor (ventilatoarele ajungând pe la 16000rpm). Așa că am avut de muncă cu o răcire custom, am înlocuit 3 dintre ventilatoarele originale cu Noctua de 60mm cărora le-am printat o cutie ca să se potrivească, apoi am pus două ventilatoare de 200mm care să răcească hdd-urile. Din păcate atunci când am populat toate bay-urile cu HDD-uri airflow-ul a scăzut foarte mult (e foarte puțin loc rămas între hdd-uri), așa că nu mai ajungea cine știe ce aer în interior, așa că am înlocuit capacul de deasupra cu ceva custom din plexiglas + holdere printate. 3 ventilatoare care bagă aer, deasupra CPU-urilor și deasupra controller-ului de HDD-uri, care se încălzea destul de tare, și o ieșire care e cuplată direct la un tub care evacuează aerul cald afară (pe care-l folosesc și la imprimantă, dacă printez plastice dubioase).

Stocarea are 3 "niveluri", un RAID1 din 2 SSD-uri de 2TB pentru VM-uri care "merită", un RAID10 din 4 HDD-uri de 14TB (26TB utilizabili) pentru VM-uri generice și stocare pentru baze de date, și un RAID6 din 8 HDD-uri de 18TB pentru 98TB de stocare generică "lentă". Pentru RAID folosesc controller-ul onboard cu 2GB RAM cache flash-backed cu capacitor. SSD-urile sunt conectate la 2 porturi care nu-s neapărat suportate oficial, backplane-ul mai are două mufe pe spate dar nu e clar la ce se pot folosi la 380p (posibil să fie folosite la 360p sau 380e, sunt niște versiuni care au posibiltata a două bay-uri de 3.5" pe spate). Problema e că SSD-urile apar în controller ca "Degraded (Not authenticated)" pentru că nu găsește HDD tray-ul smart (cu lumini de stare etc).

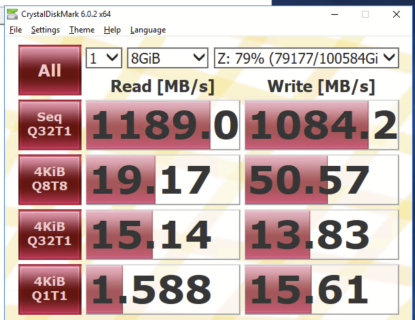

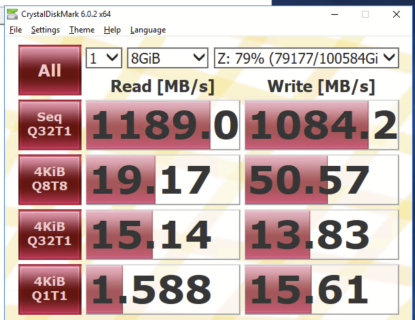

Performanța RAID6 e decentă (greu de controlat testul, sunt multe sisteme care folosesc stocarea în același timp).

OS-ul e ESXi 7 versiunea free, vedem ce-o să se întâmple cu Broadcom peste câțiva ani.

Consumul este relativ decent pentru ce e în interior, media pe la 270W cu salturi de 500W. Sursele sunt de 750W, le folosește pe ambele în paralel cu posibilitatea de switchover la nevoie. Una e prin UPS, alta e doar pe un stabilizator, dar pe altă fază.

Monitorizarea și management-ul cu iLO e normal pentru un server, cred că o singură dată am băgat un VGA în server, pentru că nu reușeam să ajung la iLO... din cauza unui cablu de rețea care nu era bine băgat în switch. Problema e pe la boot, un boot full durează minute bune, mai ales de când am pus 512GB RAM, îl numără bit cu bit se pare.

All in all, eu sunt mulțumit că acum pot ține un cluster cu 2 noduri de DB cu 128GB RAM fiecare, ca să pot face teste mai controlabile și fără bătăi de cap, plus resurse destule pentru auxiliare (shared storage, backups etc) și suport pentru tot restul chestiilor din casă.

La nevoie se mai poate expanda stocarea cu SSD-uri NVMe, având multe PCIe disponibile. Mi-ar mai plăcea o placă grafică pentru Plex.

Inițial am luat niște CPU-uri low power, 10-core dar la frecvență mică, erau ok ca consum dar mult prea lente single threaded, așa că am upgradat la 8-core mai rapide. Prețurile componentelor de genul sunt relativ ok pe ebay, CPU-urile au fost vreo 30€.

Cea mai mare problemă a fost zgomotul, pentru că serverul stă în pod, unde am și eu biroul. Drăcia are original 6 ventilatoare de 30W fiecare (da, pot consuma 180W doar ventilatoarele), pe care le turează super ok by default (13%), dar dacă încep să se încălzească lucrurile prin el (și are vreo 50 de senzori de temperatură) imediat trece de 50% și e super noisy. La 100% face ca un turboreactor (ventilatoarele ajungând pe la 16000rpm). Așa că am avut de muncă cu o răcire custom, am înlocuit 3 dintre ventilatoarele originale cu Noctua de 60mm cărora le-am printat o cutie ca să se potrivească, apoi am pus două ventilatoare de 200mm care să răcească hdd-urile. Din păcate atunci când am populat toate bay-urile cu HDD-uri airflow-ul a scăzut foarte mult (e foarte puțin loc rămas între hdd-uri), așa că nu mai ajungea cine știe ce aer în interior, așa că am înlocuit capacul de deasupra cu ceva custom din plexiglas + holdere printate. 3 ventilatoare care bagă aer, deasupra CPU-urilor și deasupra controller-ului de HDD-uri, care se încălzea destul de tare, și o ieșire care e cuplată direct la un tub care evacuează aerul cald afară (pe care-l folosesc și la imprimantă, dacă printez plastice dubioase).

Stocarea are 3 "niveluri", un RAID1 din 2 SSD-uri de 2TB pentru VM-uri care "merită", un RAID10 din 4 HDD-uri de 14TB (26TB utilizabili) pentru VM-uri generice și stocare pentru baze de date, și un RAID6 din 8 HDD-uri de 18TB pentru 98TB de stocare generică "lentă". Pentru RAID folosesc controller-ul onboard cu 2GB RAM cache flash-backed cu capacitor. SSD-urile sunt conectate la 2 porturi care nu-s neapărat suportate oficial, backplane-ul mai are două mufe pe spate dar nu e clar la ce se pot folosi la 380p (posibil să fie folosite la 360p sau 380e, sunt niște versiuni care au posibiltata a două bay-uri de 3.5" pe spate). Problema e că SSD-urile apar în controller ca "Degraded (Not authenticated)" pentru că nu găsește HDD tray-ul smart (cu lumini de stare etc).

Performanța RAID6 e decentă (greu de controlat testul, sunt multe sisteme care folosesc stocarea în același timp).

OS-ul e ESXi 7 versiunea free, vedem ce-o să se întâmple cu Broadcom peste câțiva ani.

Consumul este relativ decent pentru ce e în interior, media pe la 270W cu salturi de 500W. Sursele sunt de 750W, le folosește pe ambele în paralel cu posibilitatea de switchover la nevoie. Una e prin UPS, alta e doar pe un stabilizator, dar pe altă fază.

Monitorizarea și management-ul cu iLO e normal pentru un server, cred că o singură dată am băgat un VGA în server, pentru că nu reușeam să ajung la iLO... din cauza unui cablu de rețea care nu era bine băgat în switch. Problema e pe la boot, un boot full durează minute bune, mai ales de când am pus 512GB RAM, îl numără bit cu bit se pare.

All in all, eu sunt mulțumit că acum pot ține un cluster cu 2 noduri de DB cu 128GB RAM fiecare, ca să pot face teste mai controlabile și fără bătăi de cap, plus resurse destule pentru auxiliare (shared storage, backups etc) și suport pentru tot restul chestiilor din casă.

La nevoie se mai poate expanda stocarea cu SSD-uri NVMe, având multe PCIe disponibile. Mi-ar mai plăcea o placă grafică pentru Plex.

Last edited:

Fix la un de-asta (difera doar cantitatea de RAM) a cazut capacitorul de la controllerul de disc acum o luna intr-o fabrica Brazilia si am mers vreo 8 ore ** in regim de avarie pana am mutat pe datacenterul din celalalt colt al fabricii. Fara ala dezactiveaza cache-ul si viteza a scazut pe la 10 MB/sec.

** A durat vreo 6 ore pana s-au prins ca sunt probleme si m-au sunat, apoi vreo 2 ore pana am descoperit ce se intampla si au migrat discurile live, in timp ce o parte din aplicatii mergeau.

Imi amintesc cum fac ventilatoarele, am avut DL380 de pe la G1 sau G2 in Bucuresti, ceva G3 prin SUA, o vreme am trecut pe 385 cand Opteron erau the shit prin 2008-2010, apoi iar pe 380. Din fericire de vreo 10 ani nu ma mai ocup eu de ele.

In schimb am avut un dual-Epyc nou prin casa si era incredibil de silentios. Nu avea decat nVME si probabil airflow mult mai bun, in afara de 1 minut la pornire se putea lucra cu el la 1 metru.

** A durat vreo 6 ore pana s-au prins ca sunt probleme si m-au sunat, apoi vreo 2 ore pana am descoperit ce se intampla si au migrat discurile live, in timp ce o parte din aplicatii mergeau.

Imi amintesc cum fac ventilatoarele, am avut DL380 de pe la G1 sau G2 in Bucuresti, ceva G3 prin SUA, o vreme am trecut pe 385 cand Opteron erau the shit prin 2008-2010, apoi iar pe 380. Din fericire de vreo 10 ani nu ma mai ocup eu de ele.

In schimb am avut un dual-Epyc nou prin casa si era incredibil de silentios. Nu avea decat nVME si probabil airflow mult mai bun, in afara de 1 minut la pornire se putea lucra cu el la 1 metru.

De ce HP DL380 G8 și nu Dell R730 despre care aud numai lucruri bune pentru un home lab, inclusiv eficiența energetică mult îmbunătățită față de generațiile anterioare? Ar fi echivalent cu DL380 G9.

R730 cu 12LFF e mai greu de găsit pe la noi, iar transportul pentru un colet internațional de 25kg e măricel. Serverele noi sunt mai eficiente, eficiență reflectată și de preț (diferența de preț între R730 și DL380G8 barebone, la prețurile pe care le-am găsit atunci, era mai mare decât energia pe cel puțin 2 ani, și nu vorbim de diferența de energie, ci toată). Apoi astea folosesc DDR4, care e iar minim dublu la preț față de DDR3-ul pentru DL380 G8 (512GB DDR4 încep pe la 2000€ în stick-uri de 32GB, care-s rare, de obicei se găsesc stick-uri de 64GB la 3000€ pentru 512GB, pentru că asta e tehnologia curentă și nu se aruncă așa multă). Poate fi o soluție dacă găsești un R730 la gunoi, dar de obicei prin US se întâmplă astea (pe unde apar și ideile de home lab cu 2 rack-uri 42U), dar ăia au mult prea mult disposable income  .

.

AdrianB1: Eu am luat un controller + cache + capacitor de rezervă, ca să pot accesa backplane-ul din altă parte dacă crapă MB-ul sau ceva. Da, Epyc and stuff sunt foarte faine, dar și prețurile sunt pe măsură.

.

.AdrianB1: Eu am luat un controller + cache + capacitor de rezervă, ca să pot accesa backplane-ul din altă parte dacă crapă MB-ul sau ceva. Da, Epyc and stuff sunt foarte faine, dar și prețurile sunt pe măsură.

Nu e doar consumul, cât și gălăgia și căldura. Proiectul meu (anterior) de migrare de datacentere acum e la faza de demontat datacenterul vechi și eventual canibalizat ce mai e încă utilizabil în parametri rezonabili vreo 2-3 ani. Linia s-a tras la DL380 G9 ca minim păstrat, G8 și mai vechi merg la reciclat direct fiindcă nu merită bătaia de cap cu logistica pentru a le vinde pe eBay.

R730 cu 2x E5-2695 v4 cu 18 cores 36 threads 2,1GHz boost la 3,3 și TDP 120W, 512GB DDR4 ECC în module de 32, H730 cu 2GB și rack+caddies pentru 16 discuri de 2,5", DRAC8 și 2 surse, 2640€ cu transport gratuit din UK (dar cu TVA), ceea ce nu mi se pare prea nasol.

Pe de altă parte, dacă n-ai rack de 19", nu prea văd de ce să te legi de acest format care te constrânge din multe puncte de vedere. Un server în carcasă tower e mai flexibil la storage rack și ventilație.

R730 cu 2x E5-2695 v4 cu 18 cores 36 threads 2,1GHz boost la 3,3 și TDP 120W, 512GB DDR4 ECC în module de 32, H730 cu 2GB și rack+caddies pentru 16 discuri de 2,5", DRAC8 și 2 surse, 2640€ cu transport gratuit din UK (dar cu TVA), ceea ce nu mi se pare prea nasol.

Pe de altă parte, dacă n-ai rack de 19", nu prea văd de ce să te legi de acest format care te constrânge din multe puncte de vedere. Un server în carcasă tower e mai flexibil la storage rack și ventilație.

Exact asta ziceam și eu, chestia asta te constrânge la discuri enterprise de 2.5", care-s mici și scumpe. LFF cu aceleași specificații e mai rar/scump de obicei, pentru că e mai căutat de oameni "normali" si mai puțin întâlnit în enterprise (un HDD de 8TB 2.5" e $800 second hand, iei 50TB de LFF cu banii ăia). Un server tower nu are de obicei suport pentru multe hdd-uri și memorie puțină, nu prea am văzut cu mai mult de 8LFF. Da, probabil ar fi fost mai ușor de răcit, dar cum n-am planuri să mai adaug încă un server (și să-l țin cu răcire stock) nu are rost nici rack.16 discuri de 2,5"

Cam 3500€ a fost toată treaba cu tot cu HDD-uri (dar o parte existau deja) și ventilatoare, masă pentru pus deasupra UPS-ului etc + distracția că le-am făcut singur

. Mie mi se pare ok, până aruncă lumea sisteme mai noi.

. Mie mi se pare ok, până aruncă lumea sisteme mai noi.Neo

The Good Doctor

Mai degrabă mi-aș bate cuie-n talpă cu ciocanul de fierărie și-aș adăuga și potcoave pentru că aș fi bou complet să iau așa ceva. Într-o perioadă în care cam orice hardware-related este obscen de scump hai să ne uităm la cele mai inutil de scumpe piese16 discuri de 2,5"

Din care HDDurile au fost oricum partea cea mai mareCam 3500€ a fost toată treaba cu tot cu HDD-uri

Neo

The Good Doctor

Apropos, pentru acasă personal sunt adeptul pieselor cât mai flexibile (nu fizic). Cu cât ceva este mai specializat și mai de nișă, cu atât servisarea în caz că explodează ceva este mai dificilă.

De aia prefer ZFS - poți face import la pool pe absolut orice PC capabil să găzduiască toate HDDurile respective. Atât.

Hardware-ul enterprise este foarte mișto dar personal nu știu dacă m-aș arunca la așa ceva chiar dacă ar exista fondurile necesare, totul mi se pare foarte îngrădit și foarte specializat, da - ECC este mișto dar nu-i necesar pentru ZFS de exemplu - iar dacă pică ceva mi-e groază că trebuie să mă apuc să caut piese dubioase (gen PSU etc). Plus mai este și consumul, serverul meu ia pe la 200 W în idle ceea ce-i okish pe lună dacă închid workstation-ul când nu-l folosesc, la servere probabil doar ventilatoarele trag 200 W în idle (deși merg înlocuite cu ceva silent)

Una peste alta depinde evident de nevoi. NASurile din comerț mi se par super limitate și o platformă bazată pe un PC vechi mi se pare chiar ok cu ceva tweaking. Server-grade stuff este mișto și ăla, dar tot stocarea propriu-zisă papă bănuții cei mai mulți.

De aia prefer ZFS - poți face import la pool pe absolut orice PC capabil să găzduiască toate HDDurile respective. Atât.

Hardware-ul enterprise este foarte mișto dar personal nu știu dacă m-aș arunca la așa ceva chiar dacă ar exista fondurile necesare, totul mi se pare foarte îngrădit și foarte specializat, da - ECC este mișto dar nu-i necesar pentru ZFS de exemplu - iar dacă pică ceva mi-e groază că trebuie să mă apuc să caut piese dubioase (gen PSU etc). Plus mai este și consumul, serverul meu ia pe la 200 W în idle ceea ce-i okish pe lună dacă închid workstation-ul când nu-l folosesc, la servere probabil doar ventilatoarele trag 200 W în idle (deși merg înlocuite cu ceva silent)

Una peste alta depinde evident de nevoi. NASurile din comerț mi se par super limitate și o platformă bazată pe un PC vechi mi se pare chiar ok cu ceva tweaking. Server-grade stuff este mișto și ăla, dar tot stocarea propriu-zisă papă bănuții cei mai mulți.

Neo , cred ca privesti din perspectiva gresita: daca vrei ceva sh un hardware enterprise e de obicei mai rezistent pe termen lung decat vechiul computer al unui gamer care facea overclocking 100% din timp, inclusiv cand se uita pe YouTube, sau un NAS ieftin si vechi. Stiu multe cazuri in care un server din asta era disponibil prin SUA la sume derizorii, gen $200 cu totul, si atunci e imbatabil ca pret/performanta. Ce iti permiti e mult mai bun decat ce e bun pe piata, dar prea scump pentru nevoile tale.

Cand mi-am facut NAS-urile in ultimii 10 ani am luat in calcul asta si am ajuns la custom build din motive diverse, gen transport si taxe de adus din SUA, disponibilitatea de piese din computerul meu pe care l-am schimbat, etc. Daca eram in SUA probabil luam un sistem de genul asta, e mai flexibil decat 5600x-ul pe care il am acum in care toate porturile PCIe, SATA si M.2 sunt ocupate, precum si toate sloturile de RAM cu DIMM-uri la capacitatea maxima posibila. OK, pentru mine asta e suficient, dar daca la aceiasi bani puteam lua ceva mult mai expandabil care crezi ca ar fi fost alegerea?

Singura problema e ineficienta energetica, dar cu niste panouri pe acoperis mai carpesti la ea.

Cand mi-am facut NAS-urile in ultimii 10 ani am luat in calcul asta si am ajuns la custom build din motive diverse, gen transport si taxe de adus din SUA, disponibilitatea de piese din computerul meu pe care l-am schimbat, etc. Daca eram in SUA probabil luam un sistem de genul asta, e mai flexibil decat 5600x-ul pe care il am acum in care toate porturile PCIe, SATA si M.2 sunt ocupate, precum si toate sloturile de RAM cu DIMM-uri la capacitatea maxima posibila. OK, pentru mine asta e suficient, dar daca la aceiasi bani puteam lua ceva mult mai expandabil care crezi ca ar fi fost alegerea?

Singura problema e ineficienta energetica, dar cu niste panouri pe acoperis mai carpesti la ea.

Neo

The Good Doctor

AdrianB1 - da, desigur, overclockingul ăla strică chestii

Mie singura chestie care mi-a murit în ultimii 10 ani este o placă video... care a fost singura chestie pe care nu am oveclockat-o. Bine, și un HDD Seagate de 3TB și un WD Red de 4TB. Sunt perfect de acord că hardware-ul enterprise este super rezistent și că merită investit în el mai ales când îl găsești la preț convenabil - cazul de mai sus Nu mai spun de locașurile de HDD care la un server enterprise sunt super faine - dar există echivalente pentru PC (am două rack-uri care ocupă fiecare 2 locașuri de 5.25'' și fiecare poate înghiți 3 HDDuri de 3.5''), nu trebuie să le lipești cu bandă dublu adezivă.

Nu mai spun de locașurile de HDD care la un server enterprise sunt super faine - dar există echivalente pentru PC (am două rack-uri care ocupă fiecare 2 locașuri de 5.25'' și fiecare poate înghiți 3 HDDuri de 3.5''), nu trebuie să le lipești cu bandă dublu adezivă.

Ce încercam să spun este că depinde de nevoile personale și de bugetul disponibil, dar în general dacă pică un controller RAID dintr-un server enterprise la tine acasă ai probleme mult mai mari decât dacă face poc computerul vechi pe care rulezi ceva array ZFS (în contextul în care array-ul nu face și el poc, evident ).

).

Mie singura chestie care mi-a murit în ultimii 10 ani este o placă video... care a fost singura chestie pe care nu am oveclockat-o. Bine, și un HDD Seagate de 3TB și un WD Red de 4TB. Sunt perfect de acord că hardware-ul enterprise este super rezistent și că merită investit în el mai ales când îl găsești la preț convenabil - cazul de mai sus

Nu mai spun de locașurile de HDD care la un server enterprise sunt super faine - dar există echivalente pentru PC (am două rack-uri care ocupă fiecare 2 locașuri de 5.25'' și fiecare poate înghiți 3 HDDuri de 3.5''), nu trebuie să le lipești cu bandă dublu adezivă.

Nu mai spun de locașurile de HDD care la un server enterprise sunt super faine - dar există echivalente pentru PC (am două rack-uri care ocupă fiecare 2 locașuri de 5.25'' și fiecare poate înghiți 3 HDDuri de 3.5''), nu trebuie să le lipești cu bandă dublu adezivă.Ce încercam să spun este că depinde de nevoile personale și de bugetul disponibil, dar în general dacă pică un controller RAID dintr-un server enterprise la tine acasă ai probleme mult mai mari decât dacă face poc computerul vechi pe care rulezi ceva array ZFS (în contextul în care array-ul nu face și el poc, evident

).

).Decât niște struguri acri.